GoogLeNet

Google提出的GoogLeNet,層數比較多,運算的效率相當好,超參數數量比Alexnet少了12倍,準確率卻提升。

使用Inception,針對輸入資料同時進行不同filter尺寸的卷積處理和max pooling,最後再進行級聯,讓每一層的特徵值取得不同大小的特徵,速度也加快許多。

ResNet(Residual Neural Network)

特色是神經網路不須每一層網路都走過,可以用跳躍的方式略過某些層數。

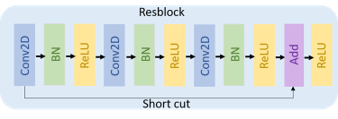

residual block

認為模型層數深,會增加Gradient Vanishing發生的問題,進而影響模型收斂,後來使用batch normalization來解決,結果顯示一般深度網路層數越多,訓練誤差不降反增,但會出現degradation的問題,隨著層數增加,導致過高的訓練誤差。

可以略過其中的網路架構,使用這個網路的優點可以避免模型的過度擬合,模型可以透過深層特徵和淺層特徵結合在一起進行判斷,同時梯度不容易消失。